Entender como o Googlebot rastreia e indexa o conteúdo da web é essencial para qualquer estratégia de SEO. O Googlebot, responsável por explorar e organizar as páginas da internet, determina como os sites aparecem nos resultados de busca, influenciando diretamente sua visibilidade e desempenho.

Neste conteúdo, vamos explorar práticas que ajudam a otimizar o rastreamento e a indexação do seu site, garantindo uma presença mais eficaz no Google e aumentando as chances de alcançar um público maior.

O que é Googlebot?

O Googlebot é o robô do Google responsável por navegar pela internet, rastreando páginas e links. Ele coleta informações essenciais para organizar e classificar sites. Esses dados alimentam a SERP, garantindo que os resultados sejam relevantes e otimizados para os usuários.

O rastreador do Google foi criado para coletar informações e gerar dados essenciais para a classificação dos sites mais relevantes, com base em critérios confidenciais estabelecidos pela empresa.

Embora os fatores exatos de classificação não sejam completamente conhecidos, práticas de SEO comprovadas podem melhorar significativamente o desempenho dos sites, aumentando sua visibilidade e posição nos resultados de busca (SERP).

Como o Googlebot funciona?

O Googlebot percorre as URLs armazenadas em seu banco de dados, iniciando pelas mais relevantes. Durante o acesso a essas páginas, ele identifica links internos e externos, adicionando-os a uma fila para rastreamento posterior. Esse processo contínuo permite que novas páginas e atualizações sejam descobertas diariamente.

A relevância de uma página influencia diretamente a frequência com que ela é visitada pelo Googlebot. As páginas com mais links apontando para elas tendem a ser rastreadas com maior rapidez, enquanto aquelas com poucos ou nenhum link podem levar mais tempo para serem revisitadas.

Outra forma de otimizar o rastreamento é por meio do envio de um sitemap em formato XML pelo Google Search Console. Esse arquivo orienta o Googlebot, indicando as páginas mais importantes de um site e acelerando sua indexação. Com isso, os proprietários têm maior controle sobre como o conteúdo é descoberto e priorizado.

Como funciona o rastreamento do site?

O rastreamento de um site é realizado por crawlers, também conhecidos como robôs de busca, que percorrem a internet coletando informações sobre páginas web. Esse processo começa com uma lista de URLs previamente conhecidas ou fornecidas, como por meio de um sitemap enviado ao Google Search Console.

Ao acessar uma página, o crawler analisa seu conteúdo, incluindo texto, imagens e metadados, além de identificar links internos e externos. Esses links são adicionados a uma fila para visitas futuras, permitindo que o rastreamento se expanda de forma contínua e eficiente.

A frequência do rastreamento depende de fatores como relevância da página, número de links que apontam para ela e frequência de atualizações. Os sites populares ou frequentemente atualizados tendem a ser rastreados com mais regularidade.

Esses dados coletados pelos crawlers são usados para atualizar os índices de busca, garantindo que os usuários encontrem resultados relevantes e atualizados ao realizar pesquisas online.

Como bloquear o acesso do Googlebot ao seu site?

Bloquear o acesso do Googlebot a um site pode ser necessário em situações específicas, como evitar indexação de páginas privadas ou conteúdo duplicado. Aqui estão algumas formas de implementar essas restrições:

1. Arquivo robots.txt

Adicione regras no arquivo robots.txt, que deve ser colocado na raiz do site. Por exemplo:

User-agent: Googlebot

Disallow: / Esse comando bloqueia o Googlebot de acessar todas as páginas do site. Para bloquear seções específicas, substitua / pelo diretório desejado.

2. Meta Tag Robots

Inclua a meta tag no cabeçalho das páginas que deseja bloquear:

<meta name="robots" content="noindex, nofollow">Isso impede a indexação e o rastreamento de links da página onde esse código HTML foi inserido.

3. Configuração de cabeçalhos HTTP

Configure o servidor para retornar um cabeçalho HTTP com a diretiva X-Robots-Tag, como no exemplo abaixo:

X-Robots-Tag: noindex, nofollowEssa abordagem é útil para bloquear arquivos não HTML, como PDFs. É possível realizar esse procedimento criando regras no arquivo .htaccess. No exemplo abaixo vamos impedir os arquivos PDF de serem indexados (por questões de segurança):

<Files ~ "\.pdf$">

Header set X-Robots-Tag "noindex, nofollow"

</Files>4. Senha ou Autenticação

Para restringir o acesso de crawlers ao seu conteúdo, você pode utilizar autenticação HTTP básica ou proteger diretórios com senha diretamente no servidor.

Isso impede que crawlers, como o Googlebot, acessem páginas ou seções do site que requerem credenciais de login. Assim, você garante que apenas usuários autorizados possam visualizar determinados conteúdos, mantendo-os fora do alcance de motores de busca.

5. IP Blocking

Bloqueie o Googlebot diretamente pelo endereço IP usado por ele. Essa abordagem é menos comum e pode impactar negativamente a experiência de busca.

Isso pode ser feito direto no servidor ou no painel de hospedagem, caso essa tenha opção de filtragem de IPs. Neste caso você precisa obter a lista de IPs usados pelo Robô do Google para realizar o bloqueio deles.

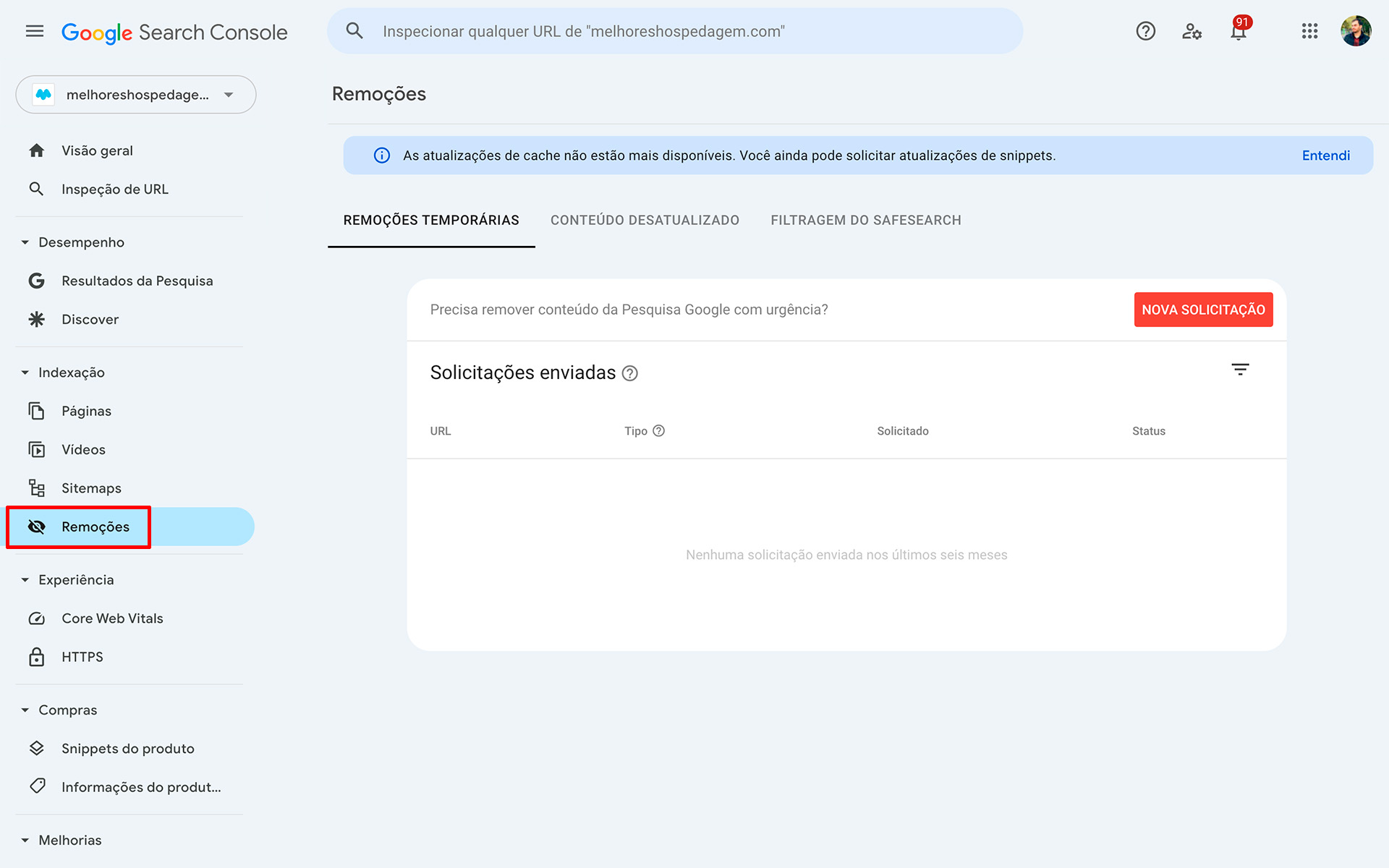

6. Remoção no Google Search Console

Se uma página indesejada ou desatualizada já foi indexada, você pode solicitar sua remoção diretamente pelo Google Search Console. Ao usar essa ferramenta, é importante escolher o método adequado para garantir que o conteúdo seja removido de forma eficaz.

A escolha do processo ideal depende do tipo de página e do objetivo — seja para bloquear um conteúdo temporariamente ou permanentemente.

Qual é o impacto do Googlebot no seu site?

O impacto do buscador Google em um site é enorme, sendo a principal fonte de tráfego para a maioria das páginas na internet. Quanto melhor a classificação do site, maior será o alcance do site para milhares de usuários que utilizam o Google diariamente.

As pessoas estão constantemente pesquisando produtos, serviços ou buscando respostas para dúvidas específicas. Por isso, criar conteúdos que atendam a essas demandas é uma estratégia poderosa para atrair tráfego orgânico. Algumas buscas geram dezenas de milhares de consultas mensais.

Aliar a criação de conteúdo de qualidade com estratégias de SEO aumenta significativamente as chances de conquistar boas posições nos resultados de busca, potencializando o impacto positivo do Google no desempenho do site e influenciando diretamente o sucesso do site.

Como fazer o site ser rastreado mais rápido?

Aqui está uma lista de formas eficazes para que o site seja encontrado e apareça mais rapidamente nos resultados do Google:

1. Envie um Sitemap ao Google Search Console

Para acelerar o rastreamento do seu site pelo Google, o envio de um sitemap XML ao Google Search Console é uma das estratégias mais eficazes. Esse arquivo informa ao Googlebot quais páginas são prioritárias para rastreamento.

Além disso, o sitemap organiza as páginas do site de forma estruturada, facilitando a descoberta e a navegação pelo robô do Google. Isso aumenta as chances de as páginas serem indexadas rapidamente.

Dessa forma, o Google identifica e prioriza conteúdos importantes, otimizando a eficiência do rastreamento. Como resultado, seu site ganha mais visibilidade nos resultados de busca, atraindo visitantes de forma mais rápida e consistente.

2. Produza conteúdo relevante

Produzir conteúdo relevante e de alta qualidade é essencial para acelerar a indexação do seu site pelo Google. Quando você cria materiais que respondem a dúvidas frequentes e possuem boa demanda de buscas, o Google reconhece o valor dessas páginas.

Além disso, conteúdos relevantes atraem mais visitantes e geram interações orgânicas, como compartilhamentos e backlinks, o que reforça sua importância. Essa estratégia aumenta as chances de seu site ser priorizado pelo Googlebot, garantindo um rastreamento mais eficiente e maior visibilidade nos resultados de busca.

3. Invista em SEO

Investir em SEO é fundamental para melhorar o desempenho do seu site nos mecanismos de busca e garantir uma indexação mais rápida pelo Google. As técnicas como otimização de palavras-chave, uso de meta tags e estruturação correta do conteúdo tornam suas páginas mais atraentes para o Googlebot.

Além disso, o SEO ajuda a aumentar a relevância do site ou blog, melhorando sua posição nos resultados de busca. Quando aliado a estratégias como links internos bem planejados e conteúdos de qualidade, o SEO não apenas acelera o rastreamento, mas também potencializa o tráfego orgânico, atraindo mais visitantes qualificados.

4. Escolha um bom domínio

Escolher um bom domínio é essencial para o sucesso do seu site, mas é preciso cuidado ao registrar um domínio anteriormente utilizado. Os domínios usados em práticas maliciosas, como spam ou distribuição de conteúdo enganoso, podem estar na blacklist do Google.

Antes de registrar um domínio, pesquise o histórico do domínio para garantir que ele não tenha sido associado a atividades suspeitas. Os domínios com má reputação podem enfrentar dificuldades para ranquear bem nos resultados de busca, mesmo com esforços de SEO.

5. Registre o domínio por mais tempo

Ao Registrar o domínio por um período mais longo de tempo pode trazer benefícios significativos para o seu site. Estudos mostram que domínios com registros de 5 anos ou mais são vistos como mais confiáveis pelo Google. Isso pode resultar em uma indexação mais rápida, mesmo para sites novos com pouco conteúdo.

Ao demonstrar comprometimento a longo prazo, o domínio tende a ser considerado "amigável" aos olhos do Google, acelerando o processo de rastreamento e aumentando a chance de o site aparecer rapidamente nos resultados de busca. Essa prática oferece um diferencial competitivo, principalmente no início da jornada de SEO.

6. Construa Backlinks de Qualidade

Construir backlinks de qualidade é uma das estratégias mais eficazes para melhorar o desempenho do seu site nos resultados de busca do Google. Obter links de outros sites confiáveis e com autoridade ajuda a aumentar a relevância e a visibilidade das suas páginas.

O robozinho do Google valoriza esses links, pois considera que eles indicam que o conteúdo é valioso e merece ser destacado. Quanto mais backlinks de qualidade um site tiver, maior será sua chance de ser rastreado e classificado de forma mais rápida e eficiente, impulsionando seu tráfego orgânico.

7. Evite Erros de Rastreamento

Evitar erros de rastreamento é fundamental para garantir que o Googlebot acesse todas as páginas do seu site de forma eficiente. Utilize o Google Search Console para monitorar e identificar problemas como páginas não encontradas (erro 404) ou bloqueios inadvertidos no rastreamento.

Corrigir esses erros evita que seu site perca posições nos resultados de busca, melhorando a experiência do usuário e a indexação de novas páginas. A manutenção regular do Search Console garante que o site continue sendo rastreado corretamente, favorecendo seu desempenho nas SERPs.

Tipos de rastreadores do Google

O Google utiliza diferentes tipos de rastreadores, conhecidos como Googlebots, para acessar e indexar páginas web de acordo com as necessidades específicas de rastreamento. Os principais tipos são:

- Googlebot (Padrão): Este é o rastreador principal utilizado pelo Google para explorar páginas HTML e indexá-las nos resultados de busca. Ele é responsável por visitar a maioria dos sites da web da internet.

- Googlebot-Mobile: Este rastreador é usado especificamente para rastrear páginas otimizadas para dispositivos móveis. Com o índice "mobile-first", o Google prioriza a versão mobile do site para indexação e classificação.

- Googlebot-Image: Utilizado para rastrear imagens hospedadas nos sites. Esse bot ajuda a indexar imagens e incluir essas imagens nos resultados de pesquisa de imagens do Google.

- Googlebot-Video: Focado no rastreamento de vídeos hospedados em sites, esse bot é responsável por indexar vídeos para os resultados de pesquisa do Google, como o Google Vídeos.

- Googlebot-News: Esse bot é utilizado para rastrear conteúdo noticioso e garantir que as páginas com atualizações frequentes sejam indexadas de forma prioritária nas pesquisas de notícias.

- Googlebot-AdsBot: Usado para rastrear e verificar páginas que exibem anúncios, garantindo que os anúncios estejam funcionando corretamente e que a experiência do usuário seja otimizada.

Cada tipo de Googlebot tem sua função específica, permitindo que o algorítimo do Google organize melhor o conteúdo e forneça resultados de busca mais relevantes aos usuários.

Conclusão

Compreender o funcionamento do Googlebot e adotar boas práticas de SEO são essenciais para garantir que seu site seja encontrado rapidamente e posicionado de forma eficiente nos resultados de busca.

Desde a criação de conteúdo relevante até o envio de um sitemap, cada estratégia tem o potencial de melhorar a indexação e a visibilidade no Google. Além disso, manter o domínio limpo, evitar erros de rastreamento e buscar backlinks de qualidade são ações que aumentam as chances de sucesso a longo prazo.